Axel schrieb am

Wieder mal eine sehr interessante Zusammenfassung für Seo-Spezies und Websiteadministratoren. Am interessantesten fand ich übrigens den Hinweis zu den Rich Snippets - die waren komplett neu für mich.

Hohe Besucherzahlen sind wichtig für jegliche Form des Geld verdienens im Internet. Doch wie bringt man mehr Besucher auf die eigene Website? Dieser Artikel gibt 23 detaillierte SEO-Tipps, die für bessere Positionen in den Suchmaschinen sorgen oder neue Besucher-Kanäle eröffnen.

Duplicate Content führt sehr häufig zu Abwertungen in den Suchmaschinen. Die häufigste Ursache von Duplicate Content ist, dass Websites sowohl mit www. als auch ohne www. erreichbar sind und die gleichen Inhalte liefern (bspw. http://www.berlin.de und berlin.de), ohne dass auf eine der beiden Schreibweisen via 301 Redirect Header umgeleitet wird.

Doppelter Content führt oft zu schlechteren Positionen in den SERPs, da sich zwei Seiten die Backlinks teilen müssen, die normalerweise auf eine Seite entfallen würden und weil einmaliger (unique) Content von Google als höherwertig eingestuft wird. Versuche doppelten Content wann immer es geht zu vermeiden. Dies kannst Du via htaccess erreichen (beste Lösung) oder über das Canoncial Tag.

Folgender Code in der Konfigurationsdatei .htaccess sorgt für eine permanente Umleitung der www.domain.tld auf die domain.tld:

RewriteEngine On

RewriteCond %{HTTP_HOST} !^domain\.tld$ [NC]

RewriteRule ^(.*)$ http://domain.tld/ [L,R=301]Eine weitere Möglichkeit, doppelten Content zu vermeiden, ist das Canoncial Tag. Das Canoncial-Tag wird sowohl von Google als auch von BING unterstützt. Es wird wie folgt im <head> Bereich des HTML Codes eingefügt. Der folgende Canoncial-Tag fände z.B. für die URL www.domain.tld/produkte Verwendung:

<html>

<head>

<link rel="canonical" href="http://www.domain.tld/produkte" />

</head>

</html>

"Content is king" (Inhalte sind der Königsweg) lautet eine der ultimativen SEO-Wahrheiten. Achte daher darauf, wo immer möglich, Deine Besucher dazu zu animieren, Content auf Deiner Seite zu erstellen (User Generated Content). Folgende Website Bereiche eignen sich besonders gut für User Generated Content:

Denke aber daran, dass Du fremde Inhalte redaktionell überprüfen solltest und darauf, dass Du keine Spam-Beiträge veröffentlichst. Verwende hierzu z.B. Spam-Shields (hier am Beispiel von TYPO3).

Die Gliederung von Web-Texten mit Überschriften ist nicht nur wichtig, um eine gute Lesbarkeit zu gewährleisten, sondern hat zudem auch positive Auswirkungen auf die Suchmaschinenoptimierung. So können Suchmaschinen die einzelnen Text-Abschnitte semantisch besser einordnen und Keywords aus den Überschriften herausziehen. Ein weiterer positiver Aspekt ist, dass eine gute Gliederung automatisch die logische Struktur eines Textes verbessert.

Häufig aktualisierte Seiten werden von Google öfter indiziert, erhalten bessere Positionen in den SERPs und erhalten bei ausreichender Qualität einen höheren Trust als vergleichbare Seiten. Häufig werden diese Seiten auch mit einem höheren Pagerank belohnt. Integriere daher falls möglich einen News-Bereich, einen Blog, ein Artikelverzeichnis oder ein Forum in Deine Website, um für regelmäßig neuen aktuellen Content zu sorgen.

Mit Longterm Suchbegriffen, wie z.B. SEO Berlin lässt sich meist mehr erreichen. Dies liegt zum Einen daran, dass nach Longterm Suchbegriffen häufiger gesucht wird (spezielle Suchanfrage liefern bessere Ergebnisse für den Nutzer), zum anderen daran, dass die Anzahl der Wettbewerber geringer ist und man daher mit Longterm Keywords leichter besser rankt.

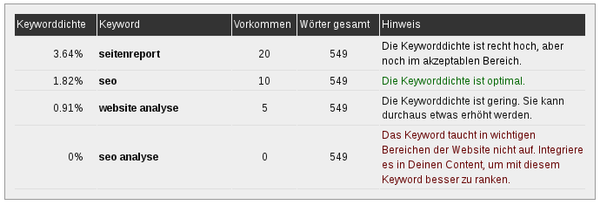

Bei der Keyword-Dichte ist es wichtig, dass diese nicht zu hoch und nicht zu niedrig liegt. Eine zu hohe Keyword-Dichte (über 5%) kann leicht als Keyword-Spamming angesehen werden und in den Suchmaschinen mit schlechten SERP-Positionen abgestraft werden. Eine zu niedrige Keyword-Dichte (unter 0,7%) holt hingegen nicht das Optimum aus einem Text heraus und verhindert unter Umständen ein gutes Ranking, selbst wenn alle anderen Faktoren optimal sind.

Bei der Wahl der Keyworddichte ist zudem darauf zu achten, dass ein Text umso langweiliger wirkt, je häufiger in kurzer Frequenz die selben Keywords auftauchen. Eine Keyworddichte von 1% bedeutet beispielsweise, dass jedes 100. Wort das Keyword ist. Die optimale Keyworddichte gemessen an Lesbarkeit und Optimierung sollte zwischen 1,5% und 3% liegen. Über unseren transparenten Keyword Density Checker kannst Du Deine Keyworddichte automatisch prüfen lassen.

Bei der Wahl der Keyworddichte ist zudem darauf zu achten, dass ein Text umso langweiliger wirkt, je häufiger in kurzer Frequenz die selben Keywords auftauchen. Eine Keyworddichte von 1% bedeutet beispielsweise, dass jedes 100. Wort das Keyword ist. Die optimale Keyworddichte gemessen an Lesbarkeit und Optimierung sollte zwischen 1,5% und 3% liegen. Über unseren transparenten Keyword Density Checker kannst Du Deine Keyworddichte automatisch prüfen lassen.

Die besten Optimierungsmaßnahmen bringen nichts, wenn Du den Erfolg oder Misserfolg nicht überwachen kannst, da Du sonst nie wirklich weißt, was eine Maßnahme gebracht hat oder ob Du mit anderen Mitteln nicht vielleicht mehr erreicht hättest. Eine Überwachung Deiner Keyword-Positionen in den SERPs (Search Engine Result Pages) hilft Dir, den Überblick über Deine SEO-Maßnahmen zu behalten und Strategien zu erkennen, die Dir den meisten Nutzen bringen. Zur Überwachung der Keyword-Positionen bei Google eignet sich z.B. das kostenlos Programm Free Monitor for Google von Cleverstat.

Achte darauf, für Deine Website optimale Keywords zu verwenden. Hier ist eine umfassende Keyword-Recherche meist unumgänglich, da vor allem die Suchvolumina abgeschätzt werden müssen. Auch können Synonyme eines Wortes zuweilen höhere Suchvolumina erreichen oder weniger Konkurrenz besitzen. Mit dem Google Adwords Keyword Tool kannst Du Suchvolumina schätzen und für Dich optimale Keywords finden.

Keywords in der URL, im Title oder in der Meta Description werden im Google Suchergebnis fett hervorgehoben. Deine Webseiten erhalten dadurch bei den Besuchern eine höhere Aufmerksamkeit. Zudem erhöht sich die Wahrscheinlichkeit eines Klicks und damit die Click-Through-Rate (CTR).

Ob Du nun sprechende Links verwendest oder Deine Keywords als Variable übergibst, macht dabei keinen Unterschied. Auch dynamische URLs können von den Suchmaschinen mittlerweile sehr gut indiziert werden. Achte gleichzeitig darauf, dass Titles und Meta Descriptions interessant sind, um die Click-Through-Rate (CTR) möglichst hoch zu halten.

Im Laufe eines Website-Lebens werden immer mal wieder Inhalte oder Seiten entfernt, die Seiten-Struktur überarbeitet oder URL-Pfade geändert. Dies führt häufig dazu, dass bis dato vorhandene Backlinks nun auf nicht mehr existierende Seiten (Statuscode 404 - nicht gefunden) verweisen. Damit gehen diese Backlinks quasi verloren.

Achte daher darauf, bei einer Änderung der URL-Pfade die alten Pfade immer mittels 302 (follow) Weiterleitung auf die neuen Pfade umzuleiten (z.B. via .htaccess). Sofern Seiten komplett entfernt wurden, empfiehlt es sich, auf ähnliche Seiten oder notfalls auf die Startseite umzuleiten.

Allerdings nur dann, wenn es tatsächlich Backlinks auf diese Seiten gibt (einsehbar z.B. in den Google Webmastertools). Durchforste regelmäßig die Nicht-gefunden (404) Fehlermeldungen in den Google Webmastertools, um Seiten aufzuspüren, die nicht (mehr) erreichbar sind.Über folgenden Eintrag in der .htaccess kannst Du Backlinks von alten auf neue Seiten umleiten:

Redirect 301 /alte-seite /neue-seiteDie Anzahl und Qualität Deiner Backlinks sind sehr entscheidend für Deine Positionen in den Suchmaschinen. Es ist daher wichtig, dass Du ein kontinuierliches Linkbuilding betreibst, um Deine Backlinks beständig weiter auszubauen.

Als organischer Backlink-Aufbau wird dabei ein Vorgehen bezeichnet, bei dem die Backlinks in natürliches Art und Weise wachsen. So sollten beispielsweise eher jeden Monat 100 Backlinks unterschiedlicher Stärke und Qualität aufgebaut statt einmal jährlich 1200 Backlinks, die z.B. alle einen Pagerank 3 besitzen.

Backlinks aufzubauen ist gar nicht so schwer, wie es anfangs aussieht. Lese Dir als Einstieg unseren Artikel 10 Quellen kostenloser Backlinks durch, um Dir vorab ein solides Backlink-Fundament aufzubauen.

Verlinke in Deinen Artikeln auf themenrelevante Artikel oder URLs von Autoritäten-Websites. Autoritäten im Internet kennt man an einem oder mehreren der folgenden Indizien:

Autoritäten genießen eine höhere Glaubwürdigkeit als andere Seiten. Seitenreport beispielsweise ist eine solche Autorität. Durch eine Querverlinkung auf Autoritäten-Websites zeigst Du den Suchmaschinen, dass Dein Artikel qualitativ als hochwertig einzustufen ist. Du bekommst quasi durch die Verlinkung einen Teil der Glaubwürdigkeit der Autoritäten-Website ab.

Der Linksaft (Link-Juice) wird zu gleichen Anteilen auf alle auf einer Seite vorhandene interne und externe follow und nofollow Links verteilt. Achte darauf, dass Du den Link-Juice optimal steuerst und auf die Seiten lenkst, die hoch gerankt werde sollen. Es bringt Dir z.B. eher wenig, wenn die meisten Deiner internen Links auf eine unbedeutende Seite verweisen, bringt Dir das aus SEO-Sicht relativ wenig. Über den Link Juice Checker kannst Du Deinen Linksaft analysieren und Optimierungsmöglichkeiten finden.

Tagtäglich werden hunderte Websites gehackt. Aus SEO-Sicht ist dabei nicht nur die Tatsache ausschlaggebend, dass Besucher eine gehackte Website sofort wieder verlassen und Kriminelle an hinterlegte Daten gelangen, sondern vor allem, dass gehackte Websites bei Google oftmals mit einer Sicherheitswarnung hinterlegt werden: "Diese Website könnte Ihren Computer gefährden".

Eine solche Warnung führt dazu, dass nahezu niemand die Website mehr aufruft. Folgende Basis-Sicherheits-Praktiken sind daher beim Betreiben einer Website auch aus SEO-Sicht nahezu unumgänglich:

Server-Administratoren müssen sich mit der Materie natürlich etwas tiefgehender befassen, Diese sollten mindestens die folgenden Punkte beachten:

Falls Du Wordpress verwendest, lese als Ergänzung den Artikel 9 SEO Security Tips for Wordpress. Auch solltest Du die Sicherheit Deines PCs nicht außer Acht lassen, denn ein Angriff auf Deine Website kann auch über den Weg Deines PCs erfolgen (FTP Zugangsdaten ausspionieren, Roadmaps und Prototyp-Code entwenden usw.). Regelmäßige Informationen zur PC-Sicherheit findest Du u.a. bei secuteach.

Die Ladezeit einer Website ist bei Google ein wichtiger Ranking-Faktor, der über vordere oder hintere Plätze in den Suchergebnisseiten entscheiden kann. Google nennt in seinen Web Performance Best Practices 6 Optimierungs-Möglichkeiten, wie der Onpage-Aufbau beschleunigt werden kann:

Für die Analyse und Umsetzung der einzelnen Punkte eignet sich unter anderem das Google PageSpeed Browser Plugin (Bestandteil der Seitenreport Analyse). Zudem gibt es eine Reihe von Server-seitigen Optimierungsmöglichkeiten:

Messe die Ladezeit Deiner Website zudem regelmäßig über webpagetest.org.

Auf Google News platzierte Artikel können sehr hohe Besucherströme auf die eigene Website lenken. Allerdings sind die Qualitätsrichtlinien für aufgenommene Artikel recht hoch und die positive Bearbeitung eines Aufnahmeantrages dauert meist recht lange. Wer regelmäßig hochwertige (selbst verfasste) News auf seiner Website veröffentlicht, sollte seine Website bei Google News anmelden. Google selbst hat hierzu ein Tutorial "Erste Schritte" veröffentlicht. Ausschlaggebend sollte immer die Frage sein, ob der eigene Content Google News einen Mehrwert bietet.

Social Media Portale bieten Dir die Möglichkeit, mit guten Inhalten oder interessanten Tools in kurzer Zeit eine sehr große Reichweite zu erreichen. Insbesondere die Möglichkeit der leichten Weiterverbreitung ("gefällt mir", "Retweet", "+1", Guerilla Marketing usw.) können Social Media zu einem sinnvollen Standbein Deiner Suchmaschinenoptimierung machen. Folgende Social Media Portale solltest Du kennen und regelmäßig für die Verbreitung Deiner Artikel und Inhalte nutzen:

Die Absprungrate (auch Bounce Rate) gibt nach der Definition der Web Analytics Association (WAA) Aufschluss darüber, wie viele Besucher eine Seite nach nur einem Seitenaufruf wieder verlassen. Je nach Analytics-Software werden auch Kurzbesuche zwischen 5-10 Sekunden in die Absprungrate eingerechnet.

Du kannst die Absprungrate auf Deinen Seiten unter anderem sehr gut mit Google Analytics überwachen. Die Bounce-Rate ist meistens umso höher, je mehr Besucher den Einstieg über Suchmaschinen finden (da diese z.B. nach einem Suchbegriff suchen und das Ergebnis ggf. nicht 100%ig zum Gesuchten passt).

Behalte Seiten mit einer hohen Absprungrate besonders im Auge und versuche, diese zu optimieren (thematisch bessere Suchbegriffe, besseres Webdesign, höhere Benutzerfreundlichkeit, bessere Texte, Spannung, Interessantes für den Besucher usw.). Alle Absprungraten über 50% sollten näher betrachtet werden.

Als Uptime wird die prozentuale Zeit bezeichnet, in der eine Website erreichbar ist. Synonym dazu ist die Downzeit diejenige Zeit, in der eine Website nicht erreichbar ist. Eine Nicht-Erreichbarkeit kann Ortsbezogen sein. So kann eine Website beispielsweise von deutschen Internetanschlüssen problemlos erreichbar sein und es gleichzeitig beim Aufrufen von Frankreich aus Probleme geben.

Daher ist es beim Messen der Uptime wichtig, die Website nicht nur selbst im Browser aufzurufen, sondern auf externe Tools zurückzugreifen, die die von verschiedenen Standorten aus auf eine Website zugreifen können. Ein ideales Tools zur Messung der Uptime ist das Pingdom Website Monitoring, welches in der Standard-Version kostenlos ist.

Wahlweise kann man sich von Pingdom bei einer etwaigen Downtime direkt per E-Mail benachrichtigen lassen, so dass schnell gehandelt werden kann. Achte bei deiner SEO auf eine hohe Uptime, da sich zu viele Ausfälle negativ auf Deine Positionen in den Suchmaschinen auswirken kann (hohe Downtime = nicht so qualitativer Service). Die Uptime sollte mindestens bei 99,5% liegen.

Regionale Angebote werden in der Google Suche oberhalb der regulären Suchergebnisse angezeigt. Durch den Einbau von GEO-Koordinaten (Orts-Bezogenheit) kannst Du Deine Besucherzahlen daher insbesondere bei regionalen Suchen erheblich steigern.

<html>

<head>

<meta name="geo.region" content="DE-SN" />

<meta name="geo.placename" content="dresden" />

<meta name="geo.position" content="51.03983;13.748498" />

<meta name="ICBM" content="51.03983,13.748498" />

<meta name="DC.title" content="SG Dynamo Dresden" />

</head>

</html>

Mikroformate (auch Rich Snippets genannt) erweitern Suchergebnisse mit Zusatzinformationen und helfen ihnen Informationen semantisch besser einzuordnen. So kann z.B. neben einem Artikel ein Autorenfoto angezeigt werden oder die Bewertung eines Artikels mit in die Anzeige in den Suchmaschinen-Ergebnissen mit einfließen. Google unterstützt dabei bisher Mikroformate für folgende Inhaltstypen:

Eine vollständige Dokumentation zu den Google Mikroformaten findet sich hier.

Die Verwendung von Mikroformaten ist recht einfach. Bestehendes HTML Markup wird einfach mit den Zusätzen itemscope und itemprop(erty)="abc" ergänzt:

<!-- Beispiel Mikrodaten Markup für den Inhaltstyp "Person" -->

<div itemscope itemtype="http://data-vocabulary.org/Person">

Name: <span itemprop="name">Fritz Lakritz</span>

Nickname: <span itemprop="nickname">Lafritz</span>

Website: <a href="http://www.domain.tld" itemprop="url">www.domain.tld</a>

Beruf: <span itemprop="title">Pixelschubser</span>

<span itemprop="affiliation">Pixelschubsermuster GmbH</span>

</div>Links, die ins Leere führen, verärgern nicht nur Besucher, sondern lassen zudem vorhandenen Linksaft im Nirvana verschwinden. Prüfe Deine Websites daher regelmäßig mit einem Linkchecker. Im CMS TYPO3 ist dieser ab Version 4.5 fester Bestandteil des Programmumfangs. Nutzer anderer CMS können stattdessen den Link Checker des W3C verwenden, um die Links einer Website validieren zu lassen.

Befindet sich die IP-Adresse Deiner Website in schlechter Nachbarschaft, kann das für Suchmaschinen ein Indiz dafür sein, dass Deine Inhalte eine nicht so hohe Qualität aufweisen. Verwende die Seitenreport Analyse "IP Nachbarschaft" (enthalten im Analyse-Reportaire der Premium-Mitgliedschaften), um zu prüfen, welche anderen Websites sich mit Deiner Website auf der selben IP-Adresse befinden. Die Seitenreport Analyse prüft dabei automatisch, ob die enthaltenen Domains in einer Blacklist auftauchen, was ein starkes Indiz für eine schlechte Nachbarschaft ist (werden rot markiert). Folgende Begebenheiten können darauf hindeuten, dass eine Website als schlechte Nachbarschaft angesehen wird:

SEO ist schon längst nicht mehr nur einfach SEO. Viele Aspekte aus anderen Web-, Usability-, Programmierungs-, Security- und Marketing-Bereichen spielen mittlerweile mit in die Suchmaschinenoptimierung hinein. Diese Entwicklung wird sich weiter fortsetzen, da Suchmaschinen immer stärker diese anderen Faktoren mit berücksichtigen. Es ist daher unumgänglich, sich mit dem vollen Web-Bereich zu beschäftigen, wenn man eine langfristig ausgerichtete Suchmaschinenoptimierung betreiben möchte.

Natürlich müssen nicht alle Punkte die Best-Practices jeden Suchmaschinenoptimierers und Website-Betreibers sein. Ich habe diese zusammengetragen in der Hoffnung, dass sie Anfängern helfen und Profis unter Umständen neue Ideen vermitteln.

Wieder mal eine sehr interessante Zusammenfassung für Seo-Spezies und Websiteadministratoren. Am interessantesten fand ich übrigens den Hinweis zu den Rich Snippets - die waren komplett neu für mich.

Eine sehr schöne Auflistung der richtigen Möglichkeiten und Traffic zu generieren. Der Bereich Social Media Marketing und Absprungrate sind meines Erachtens die wichtigsten Aspekte des ganzen. 2012 und die damit verbundenen Google Updates haben die Richtung gezeigt die Google gehen wird. Der Backlinkaufbau wird immer weiter in den Hintergrund treten und einzigartiger guter Content und Mehrwert für den Besucher wird im Vordergrund stehen. Viele Websitebetreiben wurden im letzten Jahr wegen in den Google Rankings nach Hinten geschoben weil sie sich zu sehr auf das Aufbauen von Backlinks beschränkt haben. Die Betreiber die schon seid einer langen Zeit Content und Mehrwert für Ihre Besucher erstellen haben von diesen Updates nicht wirklich viel mitbekommen. Keine Frage, SEO und Backlinkaufbau wird auch in Zukunft noch funktionieren. Aber es wird immer mehr zur kurzfristigen Angelegenheit. Wie in diesem Artikel wunderbar beschrieben ist es wichtig regelmäßig qualitativ hochwertigen Content zu liefern und den Lesern die Möglichkeit einzuräumen mitzuwirken. Es wäre doch schön sich keine Gedanken mehr um Backlinks zu machen, weil Leser Ihre Homepage von alleine weiterempfehlen! Nur das ist ein Natürlicher Link Juice und natürlicher Backlinkaufbau.

LG

Danke für die Auflistung und Anregungen. Hilfreiche Tipps befolge ich immer gerne, macht weiter so!

Vielen Dank für die Tips!

Ich hoffe, meine Seiten so stetig verbessern zu können.

Ein regelmäßiger Besuch auf eurer Seite zum Informieren und um eine Analyse zu machen ist nun gewiss

Geile Zusammenfassung Matthias, gute Links dabei! Als ich den Titel gelesen hab, dachte ich ok, da kennst du doch sicherlich schon 21 der 23 SEO-Tipps, aber war tatsächlich viel mehr unbekannte dabei. Ein paar URLs sind bereits gebookmarkt

Das mit dem Linkjuice ist ein sehr guter Tipp. Habe gerade gesehen das ich da doch sehr viel verschenke. Danke!

Hallo,

das sind ne Menge Informationen, die man erst "verdauen" muss.

Aus unserer Erfahrung bringt der erste Punkt (Vermeidung Double Content)insbesondere bei einer älteren Homepage einen wirklich sehr großen Effekt. Mit einer 301-Weiterleitung der www.-Adresse auf die Startseite waren wir schlagartig "sichtbar" (gemessen mit diversen Tools und deren Kennzahlen z.B. OVI-Index).

Hallo, eine gute Zusammenfassung zum Thema SEO, vielen Dank für den Artikel. gerade wer sich erst seit kurzem mit dem Thema beschäftigt, ist allein aufgrund der Masse an Artikeln zum Thema SEO dankbar für qualitativ brauchbare Informationen wie diese, Gruss aus Ungarn, el.pe

Hallo,

vorab gute Zusammenstellung. Nur der Punkt 1 macht mich stutzig. Ich habe jetzt schon ein paar mal gelesen, dass es bei Google keinen doppelten Content im Sinne von http://firmdeal.de bzw. www.firmdeal.de gibt. Google soll nur etwas abstrafen, wenn Content von Seite X auch tatsächlich auf einer anderen Seite y auftaucht, also dass ein und der selbe Content auf zwei unterschiedliche Seiten steht. Ich kann das jetzt nicht abschließend beurteilen, ich hoffe das klärt sich irgendwann.

MfG.

Hallo Matthias,

erstmal vielen Dank für die tolle und ausführliche Zusammenstellung. Allerdings kann ich deine Ausführungen (die wahrscheinlich auch google so sieht) bzgl. der Absprungrate teilen. In meinen Augen ist es toll, wenn der user auf einer Seite landet und dort direkt die gewünschten Infos findet. Dann muss er (auch intern) nicht weiterklicken, was sehr nutzerfreundlich ist. Aber das erhöht die Absprungrate enorm (ich glaube das auch die Absprungrate bei wikipedia deutlich über 50% liegt).

Somit wäre ein Ausweg, Landingpages und/ oder Brückenseiten zu erstellen, was die Absprungrate dann spürbar senkt. Ist das nutzerfreundlich?

Aber ansonsten kann ich den restlichen Ausführungen uneingeschränkt zustimmen und übersende

viele Grüsse

Mathias

Hallo Matthias,

vielen dank für die hilfreichen Tipps, die ich direkt und leicht umsetzen konnte.

Ich freue mich auf weitere news von dir!

Beste Grüsse aus Zürich

@Christian: Google sagt zwar immer, dass sie das Problem des Duplicate Content mittlerweile recht gut im Griff hätten, die Realität sieht aber (leider) noch anders aus. Dies liegt vor allem daran, dass www. und nicht-www. Website tatsächlich auch verschiedene Inhalte aufweisen können und durch die stetige Dynamisierung (News-Bereiche, Kommentare, dynamische Inhalte etc.) nicht mehr klar gesagt werden kann: Die Inhalte dieser beiden Seiten sind identisch oder sind es nicht. Die Problemfrage, vor der auch Google steht ist: ab wieviel % Übereinstimmung ist eine Website keine eigenständige Website mehr.

Beste Grüße,

Matthias

Vielen Dank für die tolle Beschreibung. Man stellt doch immer wieder fest, dass viele Details zu beachten sind. Ich bin jedoch immer noch sehr vorsichtig mit der Menge der SEO Aktivitäten. Denn weniger kann manchmal auch mehr sein.

Aber schön hier mal alles auf einen Blick zu bekommen. Danke + Gruß, Alexander

Vielen Dank für den sehr informativen Artikel. Einige Fakten über die Suchmaschinenoptimierung wusste ich schon, aber einige Details sind noch nicht so bekannt für mich. Werde in Zukunft besser darauf achten.

Ich freue mich auf weitere interessante Beiträge.

Viele Grüße Birgit

Hervorragend zusammengefasst

Wir arbeiten viel mit Seitenreport und auch mit hier zur Verfügung gestellten Informationen und sind immer wieder überrascht was es doch noch zu optimieren gibt, weiter so!!!

Dieser Artikel ist echt hilfreich. Ich werdehierher noch das ein oder andere mal kommen.

auch wenn ich weder PHP noch MySQL verwende

Danke für die informativen Tipps; vieles davon war mir neu.

Für mich ganz besonders interessant fand ich die Hinweise zum Thema GEO-Tags für regionale Angebote. Ich werde demnächst versuchen, dies auf meiner privaten Webseite umzusetzen.

Viele Grüße von der Bergstrasse

Andreas

Wirklich gute Arbeit geleistet! Mich beschäftigt noch immer die Sache mit dem Doppelten Content, Google sollte dies doch schnallen, doch die Realität sieht anders aus. Finde die Zusammenfassung hier echt gut, weiter so!

Mit vielen Grüßen,

Sascha von Gewinnspiel World

Vielen Dank fürs diese tollen Tipps...muss nur noch herausfinden, wie ich in meinen Shop mit Prestashop eine Kommentarfunktion einbinden kann- falls jemand einenTipp hat, wäre ich sehr dankbar.

Seit kurzem erst befasse ich mich mit dem Thema SEO und daher ist das eine für mich sehr interessante Seite.

Vor allem die Themen GEO-Tags und Rich Snippets sind mir neu und ich werde mich intensiv damit befassen.

Vielen Dank für die Infos und viele Grüße

Christine Kläger

Vielen Dank für den spannenden Artikel. Wirklich viele nützliche Tipps.

Herzlichen Dank für die Tipps, haben mir sehr geholfen

Vielen Dank für die guten tipps. Werde wohl die Technik besser im Auge behalten.

Also wirklich toller und wertvoller Artikel, was ich gerne auch auf meinem Blog weiterempfehlen werde...

Sehr guter Artikel! Viele der Tipps waren mir noch vollkommen unbekannt. Werde mir definitiv einige davon genauer anschauen!

Vielen Dank dafür!

Sehr gute Zusammenfassung der Thematik.

Eine Anmerkung zum Thema Absprungrate: um die Absprungrate gering zu halten,

muss die Webseite auf allen Browsern und auch auf allen mobilen Endgeräten (Smartphones, Tablets) leicht zu lesen und gut bedienbar sein. Durch den zunehmenden Anteil der mobilen Browser empfiehlt es sich eine mobile Version der Seite zu erstellen oder die Webseite responsiv zu gestalten, also so dass sich die Seite an die Größe des Browserfensters anpasst. Eine Webseite bei der auf kleinen Bildschirmen viel gescrollt und vergrößert werden muss, wird von den Usern sehr schnell wieder verlassen und die Absprungrate steigt.

Hallo,

vielen Dank für den Beitrag. Werde mich gleich wieder an die on und offpage setzen und einige Verbesserungen vornehmen. In der Hoffnung mit schwer umkämpften Keywords zumindest schon mal in die Top 100 zu landen.

Schöne Grüße

Danke, hat mir sehr geholfen das ganze Thema zu begreifen habe das jetzt mal so angewendet wie beschrieben und es hat sich schon etwas Wirkung gezeigt!

Lg Franzi

Vielen Dank für diese sehr lesenswerten Infos. Also gehe ich an die Arbeit... MfG

Genau das was ich gesucht habe - DANKE!!!